Presenta Nvidia nuevo servidor para grupos de trabajo a petaescala

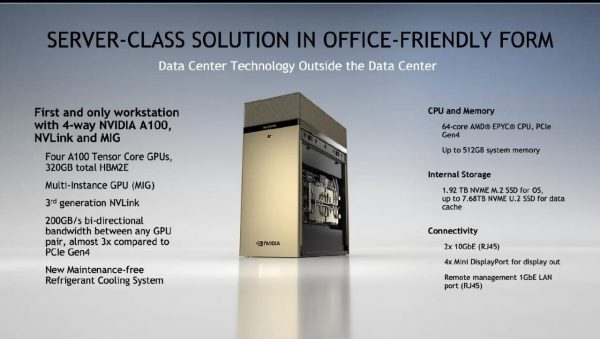

noviembre 16, 2020Este lunes se presentó al mercado el nuevo Nvidia DGX Station A100, el primer servidor para grupos de trabajo a petaescala del mundo. DGX Station A100, la segunda generación del innovador sistema de inteligencia artificial, acelera las exigentes cargas de trabajo de machine learning y ciencia de datos para los equipos que trabajan en oficinas corporativas, instalaciones de investigación, laboratorios u oficinas desde casa en todas partes.

Cuenta con 2.5 petaflops de rendimiento de IA y es el único servidor de grupos de trabajo con cuatro de las GPUs Nvidia A100 Tensor Core más recientes, totalmente interconectadas con Nvidia NVLink; lo que proporciona hasta 320 GB de memoria de GPU para acelerar los avances en la IA y la ciencia de datos empresariales.

Es también el único servidor para grupos de trabajo compatible con la tecnología de múltiples instancias de GPU de Nvidia (MIG). Con MIG, una sola DGX Station A100 proporciona hasta 28 instancias de GPU separadas para ejecutar trabajos en paralelo y admitir varios usuarios sin afectar el rendimiento del sistema.

;“DGX Station A100 saca la IA del data center con un sistema de clase de servidor que se puede conectar en cualquier lugar”, dijo Charlie Boyle; Vicepresidente y Gerente General de Sistemas DGX de NVIDIA. “Los equipos de investigadores de Ciencia de Datos e Inteligencia Artificial pueden acelerar su trabajo utilizando la misma pila de software que los sistemas NVIDIA DGX A100; lo que les permite escalar fácilmente desde el desarrollo hasta la implementación”.

Usos y eficiencia

Organizaciones de todo el mundo han adoptado DGX Station para impulsar la inteligencia artificial y la ciencia de datos en educación, servicios financieros; gobierno, atención médica y el comercio minorista.

Si bien DGX Station A100 no requiere alimentación ni enfriamiento de grado de data center, es un sistema de clase de servidor que incluye las mismas capacidades de administración remota que los sistemas de data centers Nvidia DGX A100. Los administradores de sistema pueden realizar fácilmente cualquier tarea de gestión a través de una conexión remota cuando los científicos de datos y los investigadores están trabajando en casa o en laboratorios.

DGX Station A100 está disponible con cuatro GPUs Nvidia A100 Tensor Core de 80 GB o 40 GB. Esto brinda opciones para que los equipos de investigación de ciencia de datos e inteligencia artificial seleccionen un sistema de acuerdo con sus cargas de trabajo y presupuestos únicos.

Para impulsar modelos de IA conversacionales complejas, como la inferencia de BERT Large, DGX Station A100 es más de 4 veces más rápido que la generación anterior de DGX Station. Ofrece un aumento de rendimiento de casi 3 veces para el entrenamiento de IA de BERT Large.

Los sistemas Nvidia DGX Station A100 y NVIDIA DGX A100 de 640 GB estarán disponibles este trimestre a través de la Red de socios de Nvidia de todo el mundo. Hay una opción de actualización disponible para los clientes de Nvidia DGX A100 de 320 GB.

Nuevo Chipset

Por otra parte, Nvidia presentó la próxima generación Nvidia Mellanox 400G InfiniBand que brinda a los desarrolladores de inteligencia artificial e investigadores científicos; el rendimiento de red más rápido disponible.

A medida que los requisitos de computación siguen creciendo exponencialmente en áreas como el descubrimiento de fármacos, la investigación climática y la genómica; Nvidia Mellanox 400G InfiniBand está acelerando este trabajo a través de un salto espectacular en el rendimiento ofrecido mediante la única plataforma de computación en la red totalmente descargable del mundo.

La séptima generación de Mellanox InfiniBand proporciona una latencia ultrabaja y duplica la tasa de transferencia de datos con NDR 400 Gb/s. También agrega nuevos motores de computación en la red de Nvidia para proporcionar una aceleración adicional.

Los principales fabricantes de infraestructura tecnológicas del mundo, incluidos Atos, Dell Technologies, Fujitsu, Inspur, Lenovo y Supermicro; planean integrar las soluciones Nvidia Mellanox 400G InfiniBand en sus ofertas de HPC y soluciones empresariales. Estos compromisos se complementan con una amplia compatibilidad de parte de los principales socios de infraestructura de almacenamiento, como DDN e IBM Storage, entre otros.

Mas capacidad

Nvidia Mellanox NDR 400G InfiniBand ofrece el triple de densidad de puertos del switch y aumenta la potencia de aceleración de la IA en 32 veces. Además, aumenta 5 veces el rendimiento bidireccional combinado con el sistema de switches, hasta lograr 1.64 petabits por segundo. Esto les permite a los usuarios ejecutar cargas de trabajo más grandes con menos limitaciones.

La descarga de operaciones es crucial para las cargas de trabajo de IA. La tecnología Nvidia Mellanox Sharp de tercera generación permite que las operaciones de entrenamiento de deep learning se descarguen y aceleren mediante la red InfiniBand; lo que da como resultado una potencia de aceleración de IA 32 veces mayor. Cuando se combina con la pila de software Nvidia Magnum IO, proporciona computación científica acelerada lista para usar.

Los switches de edge, basados en la arquitectura Mellanox InfiniBand, tienen un rendimiento bidireccional agregado de 51.2 Tb/s, con una capacidad histórica de más de 66,500 millones de paquetes por segundo. Los switches modulares, basados en Mellanox InfiniBand, lograrán hasta un rendimiento bidireccional combinado de 1.64 petabits por segundo, 5 veces más alto que el de la última generación.

La arquitectura Mellanox InfiniBand se basa en estándares de la industria para garantizar la compatibilidad con versiones anteriores y futuras, a fin de proteger las inversiones del data center. Se espera que las pruebas de las soluciones basadas en la arquitectura estén disponibles en el segundo trimestre de 2021.